豆包大模子重磅更新,有望带动AI应用市集隆盛

2024年12月火山引擎冬季FORCE原能源大会推出豆包视觉清爽大模子和3D分娩大模子,并对通用模子Pro、音乐分娩模子和文生图模子性能升级。字据智源研究院发布的FlagEval“百模”评测松手,豆包通用模子Pro在大言语模子总榜中主不雅评测得分最高,豆包视觉清爽模子和文生图模子在多模态模子主不雅测评中得分第二。豆包视觉清爽大模子和3D分娩大模子具备的内容识别、视觉容貌和3D内容生成才气进一步增强AI应用实用性,而使用成本比拟行业价钱可裁减85%,有望推动AI应用市集的买卖隆盛。

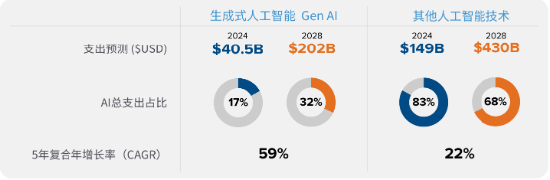

大模子的大范畴买卖化应用已纯属,拉动算力基础设施成立东说念主工智能行业已跨过AI大模子大范畴纯属买卖化应用的节点,国内厂商加大对AI Agent等新一代东说念主工智能应用的参加。AI大模子性能进步所需的千亿级参数测验及应用端隆盛对算力范畴的需求,都将推动算力基础设施的成立。字据IDC数据,2024年内行东说念主工智能本钱开支有望达2350亿好意思元,并展望2028年增长至6320亿好意思元,复合增速达29%。此外生成式东说念主工智能本钱开支2024-2028年GAGR有望达59%,权臣高于其他东说念主工智能时候的22%。

算力基础设施成立趋势下,中枢供应链才能将充分受益东说念主工智能行业带动算力基础设施成立趋势下,作事器、液冷诱导、芯片及光模块等是供应链的中枢才能。1)作事器:作事器是算力载体,AI作事器比普通作事器对算力及存储性能条件更高,2024年内行普通AI作事器和高端AI作事器出货量诀别为72.5和54.3万台,诀别同比增长54.2%和172.0%。2)液冷诱导:液冷作事器具有顽劣耗、高散热优点,合乎高算力数据中心需求;3)芯片:芯片是算力大脑,卡脖子风险最高,国产芯片亟待粉碎。4)光模块:800G和1.6T高端光模块用量有望大幅进步,国产公司在内行市集具有起初地位。

投资建议豆包大模子产品力大幅进步,并大幅裁减东说念主工智能大模子使用成本,有望推动AI应用的买卖隆盛。建议关切作事器、液冷诱导、芯片和光模块等领域的投资契机:1)作事器:海潮信息、中科晨曦;2)液冷诱导:英维克;3)芯片:海光信息;4)光模块:中际旭创、天孚通讯、光迅科技。

风险教导AI应用渗入不足预期;算力开支不足预期;宏不雅经济不足预期;竞争加重。

一、豆包大模子产品力大幅增强,推动AI应用买卖隆盛

2024年12月火山引擎冬季FORCE原能源大会推出豆包视觉清爽大模子和3D分娩大模子,并将通用模子Pro、音乐分娩模子和文生图模子升级,进一步丰富产品矩阵。2024年5月火山引擎春季FORCE原能源大会初次发布豆包大模子系列产品以来,仅7个月就再度升级,并在多项大模子才气测评榜单中居于前哨。本次大会新推出的豆包视觉清爽大模子和3D分娩大模子拓展了模子的内容识别、视觉容貌和3D内容生成才气,并权臣裁减使用成本,有望推动东说念主工智能应用端的买卖隆盛。

图1:豆包大模子产品矩阵丰富

贵府起原:火山引擎,源达信息证券研究所

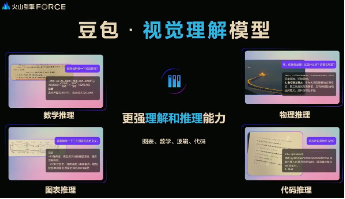

豆包视觉清爽模子具备更强内容识别才气和清爽推理才气。豆包视觉清爽模子具备高大的图片清爽与推理才气及精确的指示清爽才气。模子在图像文本信息抽取、基于图像的推理任务上有展现出了高大的性能,概况应用于更复杂、更平方的视觉问答任务。比如模子可容貌图片内容并字据图片内容进行发问。此外,该模子可完成深度的图片清爽与推理,在表格图像、数学问题、代码图像等复杂推理场景下完成任务。

|

图2:豆包视觉清爽模子具备更强内容识别才气 |

图3:豆包视觉清爽模子具备更强清爽和推理才气 |

|

|

|

贵府起原:火山引擎,源达信息证券研究所 |

贵府起原:火山引擎,源达信息证券研究所 |

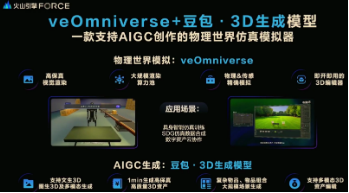

火山引擎冬季FORCE原能源大会初次发布豆包3D生成模子。该模子可支抓文生3D、图生3D及多模态生成等诸多功能,模子与火山引擎数字孪生平台veOmniverse结合使用,可高效完成智能测验、数据合成和数字钞票制作,成为一套支抓 AIGC 创作的物理天下仿真模拟器。

|

图4:火山引擎初次发布豆包3D生成模子 |

图5:豆包3D生成模子可字据文本生成3D场景 |

|

|

|

贵府起原:火山引擎,源达信息证券研究所 |

贵府起原:火山引擎,源达信息证券研究所 |

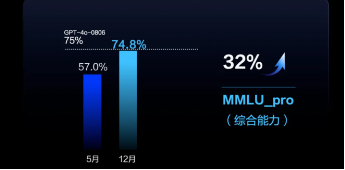

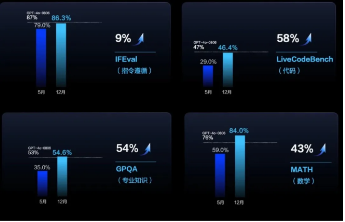

火山引擎对豆包通用模子Pro进行升级,模子性能大幅进步。豆包通用模子Pro比拟2024年5月发布版块,在抽象才气上进步32%,与GPT-4o抓平,而使用成本仅是其八分之一。模子在指示免除、代码、专科常识、数学层靠近皆GPT-4o水平,其中指示免除才气进步9%,代码才气进步58%,GPQA专科常识方面才气进步54%,数学才气进步43%,推理才气进步13%。

|

图6:豆包通用模子Pro抽象才气大幅进步 |

图7:通用模子Pro在指示免除、代码、数学等辩论对标GPT-4o |

|

|

|

贵府起原:火山引擎,源达信息证券研究所 |

贵府起原:火山引擎,源达信息证券研究所 |

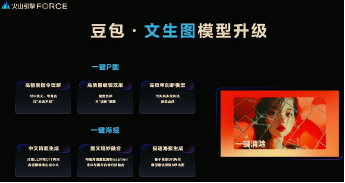

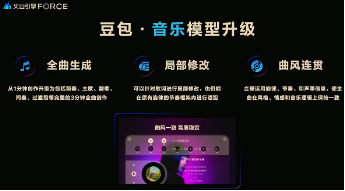

火山引擎对豆包文生图模子和音乐模子才气升级。1)豆包文生图模子:模子在通用性、可控性、高质地方面结尾粉碎,并新增一键海报和一键P图功能,可字据用户浅显指示对图片进行精确剪辑,并加强了对笔墨细节的指示免除才气。2)豆包音乐模子:可字据用户浅显容貌或上传图片,生成时长3分钟的包含旋律、歌词和演唱等元素在内的音乐作品,包括前奏、主歌、副歌、间奏、过渡段等复杂结构,并支抓局部修改功能,在针对部分歌词修改后仍能在原有旋律的节律框架内适配。

|

图8:豆包文生图模子才气升级 |

图9:豆包音乐模子才气升级 |

|

|

|

贵府起原:火山引擎,源达信息证券研究所 |

贵府起原:火山引擎,源达信息证券研究所 |

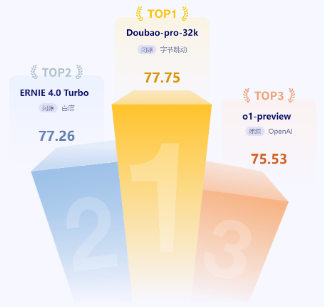

豆包大模子才气权臣进步,在多项才气测评中排行前哨。字据2024年12月19日智源研究院发布的FlagEval“百模”评测松手,在闭源大模子评测才气总榜中,豆包通用模子Pro在大言语模子总榜中主不雅评测得分最高;多模态模子评测总榜中,豆包视觉清爽模子和文生图模子的主不雅测评得分均排行第二。

|

图10:豆包通用模子Pro在大模子测评总榜中排行第一 |

图11:豆包视觉清爽模子在视觉言语模子测评榜单中排行第二 |

|

|

|

贵府起原:智源研究院,源达信息证券研究所 |

贵府起原:智源研究院,源达信息证券研究所 |

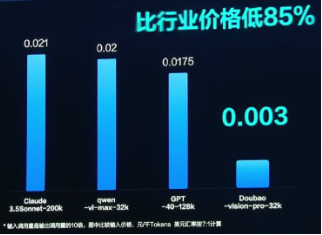

豆包视觉清爽模子使用成本大幅低于行业平均水平,有望推动AI应用买卖化纯属。字据火山引擎冬季FORCE原能源大会数据,豆包视觉清爽模子的使用成本是0.003元/千Tokens,大幅低于GPT-4o的0.0175元/千Tokens,比行业价钱低85%,大模子使用成本裁减有望推动AI应用买卖化。字据AI产品榜数据,豆包APP在2024年11月内行AI产品榜中排行第二,在末端应用的渗入率进一步进步。

|

图12:豆包视觉清爽模子使用成本大幅低于行业平均水平 |

图13:豆包APP在11月内行AI产品榜中排行第二 |

|

|

|

贵府起原:火山引擎,源达信息证券研究所 |

贵府起原:智源研究院,源达信息证券研究所 |

二、东说念主工智能产业加速增长,应用及算力是两大救援

AI大模子对算力需求大,推动AI基础设施成立。AIGC行业进入高速发缓期,AI大模子性能抓续进步的背后是千亿级以上的参数测验,带来对算力的高额需求,有望推动新一轮AI基础设施成立。字据OpenAI官网,AI模子测验缱绻量自2012年起每3.4个月就增长一倍。以GPT-3模子为例,字据lambdalabs数据,该模子参数范畴达1750亿,好意思满测验运算量达3640PFlop/s-days(以3640PFlop/s速率进走运算,需要3640天)。模子完成单次测验约需要355个CPU年并耗尽460万好意思元(假定选拔Nvidia Tesla V100芯片)。

表1:东说念主工智能大模子的参数范畴呈指数级增长趋势

|

Models |

Release time |

Developers |

Parameter size/10-8 |

Sample size/10-9 |

|

GPT-1 |

2018 |

OpenAI |

1.17 |

10 |

|

BERT |

2018 |

|

3.40 |

34 |

|

GPT-2 |

2019 |

OpenAI |

15.00 |

100 |

|

Fairseq |

2020 |

Meta |

130.00 |

— |

|

GPT-3 |

2020 |

OpenAI |

1750.00 |

4990 |

|

GLaM |

2021 |

|

1200.00 |

16000 |

|

LaMDA |

2022 |

|

1370.00 |

15600 |

|

GPT-4 |

2023 |

OpenAI |

— |

— |

|

Ernie Bot |

2023 |

Baidu |

— |

— |

|

SparkDesk |

2023 |

iFLYTEK |

1700.00 |

— |

|

PanguLM |

2023 |

HUAWEI |

>30000 |

贵府起原:《大言语模子研究近况及趋势》,源达信息证券研究所

高算力需求紧迫,推动AI基础设施成立。高测验算力需要与相应基础设施匹配,字据《2022-2023中国东说念主工智能缱绻力发展评估敷陈》展望,2024中国智能算力范畴将达641EFlop/s,同比增长50%,并展望2025年中国智能算力将达923Eflop/s,同比增长44%。。

|

图14:展望2022-2024年内行AI支拨年增速高于20% |

图15:展望2024年中国智能算力范畴同比增长50% |

|

|

|

贵府起原:IDC,天下银行,源达信息证券研究所 |

贵府起原:IDC,源达信息证券研究所 |

IDC展望2024年内行东说念主工智能本钱开支达2350亿好意思元,并展望2028年增长至6320亿好意思元,复合增速达29%。此外生成式东说念主工智能本钱开支2024-2028年GAGR有望达59%,权臣高于其他东说念主工智能时候的22%。

图16:IDC展望2024-2028年内行东说念主工智能本钱开支复合增速GAGR达29%

贵府起原:IDC,源达信息证券研究所

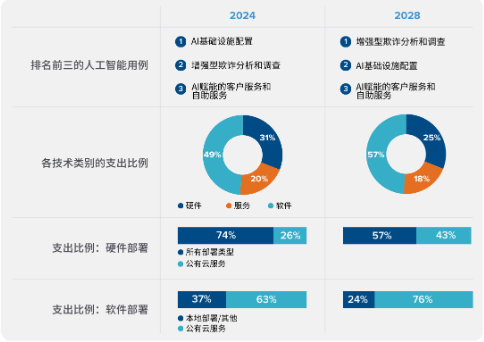

字据IDC数据,东说念主工智能支拨排行前三的行业是软件和信息作事、银行及零卖业,展望在2024 年的AI投资达896亿好意思元,占内行市集的38%。银行业将权臣增多对欺骗分析和拜访等AI作事的需求。而软件开支曩昔在东说念主工智能支拨中占比最高,展望将权臣带动IAAS、SAAS、PAAS等云表作事市集的增长。

图17:IDC展望2028年软件本钱开支将占东说念主工智能支拨的57%

贵府起原:IDC,源达信息证券研究所

大模子加速发展趋势下,国内厂商加大对AI Agent等新一代东说念主工智能应用的参加。AI Agent是一种以AI大模子驱动的东说念主工智能用具,可字据具体场景结尾高度个性化和智能化的智能作事,有望将大模子的后劲最大化,推动AI时候应用化,加速东说念主工智能产业买卖化。

表2:国内厂商加大对AI Agent等大模子驱动下的东说念主工智能应用的参加

|

公司称号 |

大模子产品 |

|

阿里云 |

百真金不怕火大模子作事平台 |

|

AWS |

Amazon bedrock 以及partyrock.aws等用具 |

|

百度智能云 |

TiAppBuilder、AgentBuilder |

|

京东云 |

Al Agent开发料理平台 |

|

蚂集聚团/蚂蚁数科 |

蚂蚊Al Studio+Max |

|

昆仑万维 |

SkyAgents |

|

商汤科技 |

MaaS平台-应用智能体 |

|

治服服科技 |

AI算力平台 |

|

神州数码 |

神州问学-AI应用及Agent料理 |

|

腾讯云 |

腾讯元器 |

|

月之暗面 |

Kimi Plus |

|

中国电信(天翼AI) |

智能体开发运营平台 |

|

字节高出 |

火山引擎Al Agent开发料理平台、豆包APP |

|

360 |

360智脑、360智汇云 |

贵府起原:IDC,源达信息证券研究所

三、算力产业链:作事器是算力基础设施

1.大模子灵通算力需求,作事器成立范畴快速增长

大模子发展灵通算力需求,AI算力作事器需求有望增长。自OpenAI发布ChatGPT后,AI大模子有望成为助力千行万业智能化转型的底层救援。AI大模子的测验和驱动历程对对算力需求极大,展望将推动一轮算力中心的成立。以Nvidia A100作事器为例(由8个A100 GPU组成),单台作事器算力约为5Pflop/s,则测验一个具有1750亿个模子参数的大模子需要约2917台A100作事器。

表3:具有1750亿个模子参数的大模子测验一天需要约2917台Nvidia A100作事器

|

模子参数(亿个) |

350 |

700 |

1050 |

1400 |

1750 |

|

所需算力(E+8PFlop/s) |

0.63 |

1.26 |

1.89 |

2.52 |

3.15 |

|

有用算力比率(%) |

25% |

25% |

25% |

25% |

25% |

|

推行算力需求(E+8PFlop/s) |

2.52 |

5.04 |

7.56 |

10.08 |

12.6 |

|

作事器算力(PFlop/s) |

5 |

5 |

5 |

5 |

5 |

|

逐日责任时间(s) |

86400 |

86400 |

86400 |

86400 |

86400 |

|

作事器需求数(台) |

583 |

1167 |

1750 |

2333 |

2917 |

贵府起原:Nvidia官网,OpenAI,源达信息证券研究所

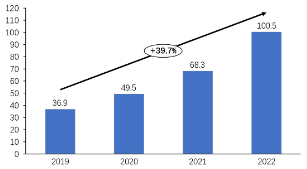

东说念主工智能行业高速发展,算力多量缺口推动AI作事器出货量高速增长。2023年内行普通AI作事器/高端AI作事器出货量诀别为47.0和27.0万台,较2022年诀别同比增长36.6%和490.5%,并展望2024年内行普通AI作事器和高端AI作事器出货量诀别为72.5和54.3万台,诀别同比增长54.2%和172.0%。

图18:AI作事器出货量高速增长

贵府起原:华勤时候投资者关系公众号,源达信息证券研究所

华为加大算力基础设施研发力度。现在华为算力基础设施布局中:鲲鹏系列以通用算力为主,昇腾系列以智能算力为主,均选拔国产芯片打造。华为凭借自己高大的研发才气,已结尾从算力、存力、互联时候和缱绻架构等方面为天下提供第二取舍,ag百家乐下载打造算力坚实底座。从产业链布局看,现在华为主要认真作事器或其中中枢器件的研发和分娩,并由卑劣作事器厂商代理销售,主要的华为系作事器厂商有高新发展(对华鲲振宇抓股70%)、四川长虹、神州数码、拓维信息和人烟通讯等。此外2023年3月中兴通讯秘书自己作事器将为百度“文心一言”提供算力救援。

|

图19:搭载鲲鹏920处理器的鲲鹏作事器主板 |

图20:华为推出昇腾系列AI算力基础设施 |

|

|

|

贵府起原:华为官网,源达信息证券研究所 |

贵府起原:华为官网,源达信息证券研究所 |

2.液冷时候顽劣耗高散热,受益算力扩建海潮

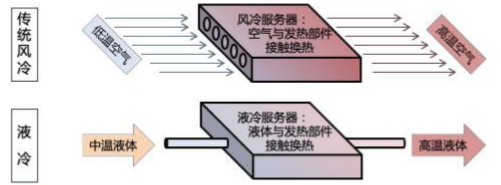

液冷时候相较于传统风冷时候,具有顽劣耗、高散热、低噪声和低TCO等优点,合乎数据中心高能耗、高密度的发展趋势:

1)高效散热:液体的冷却才气是空气的1000-3000倍,使得液冷时候更适用于高能耗、高功率的作事器应用场景。

2)节能降耗:液冷系统可结尾更高能效比,裁减数据中心能耗。液冷时候(尤其是浸没式液冷)可将数据中心的PUE值降至1.2以下,相较于传统风冷时候,不错省俭电量30~50%。

3)提高诱导可靠性:液冷时候不错减少因高温引起的诱导故障,延迟作事器的使用寿命,并幸免因电扇引起振动和杂音。

4)省俭空间:液冷时候允许更紧凑的作事器布局,无需像风冷那样需要较大的空气知道空间,从而省俭了数据中心的占大地积。

5)提高功率密度:液冷时候不错支抓更高的机架功率密度,得志高性能缱绻和AI应用的需求。浸没式液冷决策不错将单机架功率进步到100kW甚而200kW以上。

图21:传统风冷时候与液冷时候旨趣对比

贵府起原:晨曦数创招股讲明书,源达信息证券研究所

|

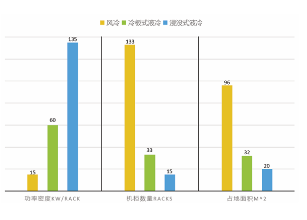

图22:液冷时候散热才气权臣优于风冷时候 |

图23:液冷时候节能水平权臣优于风冷时候 |

|

|

|

贵府起原:《中兴液冷时候白皮书》,源达信息证券研究所 |

贵府起原:《中兴液冷时候白皮书》,源达信息证券研究所 |

冷板式和浸没式等主流液冷时候在散热性、集成度、能效等冷却后果辩论上权臣优于传统风冷时候。

表4:主流液冷时候与传统风冷时候冷却后果辩论对比

|

|

传统风冷 |

冷板液冷 |

浸没单相液冷 |

浸没相变液冷 |

|

散热性能 |

0 |

+ |

+ |

++ |

|

集成度 |

0 |

+ |

+ |

++ |

|

可儿戴性 |

0 |

+ |

+ |

+ |

|

可靠性 |

0 |

+ |

+ |

+ |

|

性能 |

0 |

+ |

+ |

++ |

|

能效 |

0 |

+ |

+ |

++ |

|

废热回收 |

0 |

+ |

+ |

++ |

|

杂音 |

0 |

++ |

+ |

++ |

贵府起原:晨曦数创招股讲明书,源达信息证券研究所

东说念主工智能变革和数字经济转型趋势下,数据中心往高能耗、高密度场所发展,液冷时候应用渐广。传统的风冷方式只可得志2.7kW/机柜的数据中心散热需求,无法稳妥中高密度数据中心需求。液冷时候期骗高比热容的性情和对流传热的才气,不错得志2.7-30kW/机柜的数据中心散热需求,治理超高热流密度的散热问题,曩昔液冷时候必将在数据中心领域取得更加平方的应用。

表5:不同密度数据中心适用的冷却时候

|

每平方功率 |

数据中心密度 |

制冷方式 |

|

1.2Kw/机柜以下 |

超低密度数据中心 |

风冷 |

|

1.2-2.7kW/机柜 |

低密度数据中心 |

风冷 |

|

2.7-7.5kW/机柜 |

中、低密度数据中心 |

风冷/液冷 |

|

7.5-18kW/机柜 |

中、高密度数据中心 |

冷板式液冷 |

|

18-30kW/机柜 |

高密度数据中心 |

冷板式液冷/浸没式液冷 |

贵府起原:晨曦数创招股讲明书,源达信息证券研究所

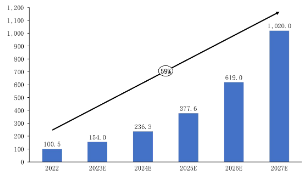

字据2023《中国液冷数据中心市集深度研究敷陈》,展望2025年中国液冷数据中心市集范畴有望达377.6亿元,同比增长56%。基于市集需求发展及产业生态成立进度,曩昔五年中国液冷数据中心市集将以59%的复合增长率抓续发展。展望到2027年,AI大模子商用落地,液冷生态趋于纯属,市集范畴将出现较大幅度增长,有望达到1020亿元。

|

图24:2019-2022年中国液冷数据中心市集范畴 |

图25:2022-2027年中国液冷数据中心市集范畴预测 |

|

|

|

贵府起原:《中国液冷数据中心市集深度研究敷陈》,源达信息证券研究所 |

贵府起原:《中国液冷数据中心市集深度研究敷陈》,源达信息证券研究所 |

四、算力产业链:芯片是智能中枢,国产化短板彰着

Nvidia H200是现在起初进的东说念主工智能芯片。2023年11月13日Nvidia推出新款东说念主工智能芯片GPU H200,与公司上一代产品H100比拟在存储性能上取得大幅进步,而在算力层面性能辩论未有权臣改革。

|

图26:Nvidia GPU H200芯片走漏图 |

图27:H200较H100比拟在存储性能上有大幅进步 |

||||||||||||

|

|

||||||||||||

|

贵府起原:Nvidia,源达信息证券研究所 |

贵府起原:Nvidia,源达信息证券研究所 |

国产AI芯片短板彰着,下一代产品鼓舞凯旋。咱们通过对国内寒武纪、华为昇腾和沐曦等国产公司旗下的AI旗舰芯片与Nvidia H100 SXM的性能辩论对比,不错看到国产AI芯片与Nvidia H100在性能上仍存在较大差距。同期国产芯片公司仍在加速研发鼓舞下一代AI芯片产品,并有望在曩昔对标Nvidia H100,如寒武纪在研的想元590、沐曦在研的MXC500等。

表6:国产AI芯片性能辩论仍与外洋顶尖水平存在较大差距

|

公司 |

Nvidia |

寒武纪 |

华为 |

沐曦 |

|

产品型号 |

H100 SXM |

想元370 |

昇腾910 |

曦想N100 |

|

FP32 |

67TFlop/s |

24TFlop/s |

/ |

/ |

|

FP16 |

1979TFlops/s |

96TFlop/s |

320TFlop/s |

80TFlop/s |

|

INT8 |

3958Top/s |

256Top/s |

640Top/s |

160Top/s |

贵府起原:各公司公告,源达信息证券研究所

好意思国对AI芯片出口管制,自主可控条件下国产芯片需求紧迫。2022年10月7日好意思国商务部工业安全局(BIS)发布《好意思国商务部对中华东说念主民共和国(PRC)对于先进缱绻和半导体实践新的出口管制制造》详情,其中管制物项3A090、4A090包含高性能AI芯片产品,而Nvidia A100和H100均合乎管制条件。在此配景下,Nvidia推出性能阉割的中国特供版芯片A800和H800。咱们合计在国内自主可控大配景下,国内AI产业对国产芯片需求紧迫,或加大对国产芯片公司支抓力度,国产AI芯片有望迎来时候进步和市集机遇。

表7:BIS禁令截止高性能AI芯片向中国出口

|

管制物项 |

管制范围 |

|

3A090 |

1、输入输出(I/O)双向传输速率高于600GB/s; 2、算力性能与精度指示比特长度乘积特出4800 |

|

4A090 |

1、含有特出3A090时候辩论芯片的缱绻机、电子组件和关连部件 |

贵府起原:好意思国商务部,源达信息证券研究所

五、算力产业链:光模块快速放量,产品结构向高端升级

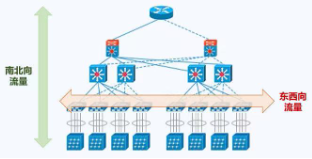

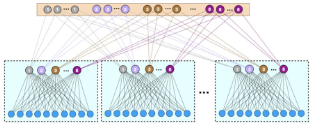

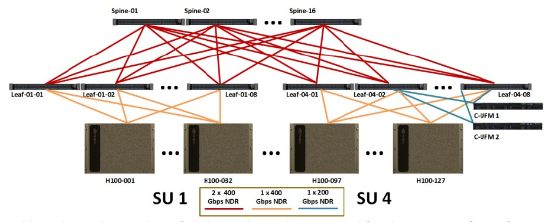

高算力需要与高效传输架构相匹配。AI大模子频频由多个作事器行为节点,并通过高速荟萃架构组成集群合营完成模子测验。因此在模子中东西向流量(数据中心作事器间的传输流量)大幅增多,而模子测验历程中南北向流量(客户端与作事器间的传输流量)较少,由于叶脊荟萃架构相较传统三层架构更适用于东西向流量传输,成为当代数据中心主流荟萃架构。

|

图28:AI大模子中东西向流量权臣增多 |

图29:叶脊荟萃架构适用于东西向流量传输 |

|

|

|

贵府起原:华为云,源达信息证券研究所 |

贵府起原:鹅厂网事,源达信息证券研究所 |

叶脊荟萃架构大幅增多对光模块数目需求。由于叶脊荟萃架构中东西向流量大,因此作事器与交换机邻接均需使用光模块,从而大幅增多对光模块数目需求。同期AI大模子的高流量对带宽提议更高条件,800G光模块相较200G/400G光模块具有高带宽、功耗低等优点,有望在AI大模子荟萃架构中渗入率进步。

表8:叶脊荟萃架构对光模块数目需求大幅进步

|

架构类型 |

传统三层架构 |

纠正等三层架构 |

叶脊荟萃架构 |

|

光模块相对于机柜倍数 |

8.8 |

9.2 |

44/48 |

贵府起原:中际旭创定向增发召募讲明书,源达信息证券研究所

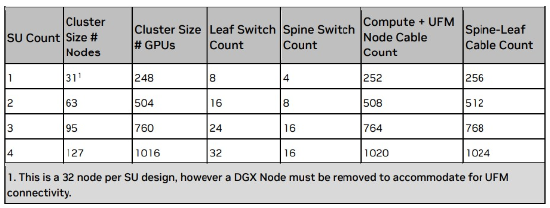

咱们以Nvidia DGX H100 荟萃架构为例。该架构适配Nvidia H100 GPU,选拔叶脊荟萃架构,分为1-4个SU单位类型(8个GPU组成一个H100作事器节点,32个作事器节点组成一个SU单位)。其中4-SU单位架构由127个作事器节点组成(其中一个节点用于安装UFM荟萃遥测安设),具有1016个H100 GPU、32个叶交换机、16个脊交换机。

表9:Nvidia DGX H100 架构所需GPU、交换机数目

贵府起原:Nvidia,源达信息证券研究所

咱们以Nvidia DGX H100架构为例测算GPU与光模块的对应数目。在4-SU的Nvidia DGX H100架构中,每32台作事器节点组成一个SU单位,并与8台叶交换机邻接,因此作事器节点与叶交换机之间共有1024个招引(32×8×4);32台叶交换机需诀别与16台脊交换机邻接,因此叶交换机与脊交换机之间共有512个招引(32×16);

在Nvidia DGX H100的现在决策中,脊-叶招引选拔800G光模块,需要1024个800G光模块;叶-作事器招引中,每个作事器节点通过一个800G光模块与两台叶交换机进取招引,需要512个800G光模块(128×4),同期每台叶交换机通过一个400G光模块与一个作事器节点招引,需要1024个400G光模块(128×8)。综上缱绻得一个4-SU单位的DGX H100架构需要1016个GPU、1536个800G光模块、1024个400G光模块,GPU:800G光模块:400G光模块的比例约就是1:1.5:1。

图30:Nvidia DGX H100 架构走漏图

贵府起原:Nvidia,源达信息证券研究所

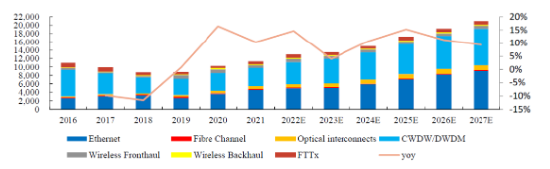

字据Lightcounting预测,内行光模块市集范畴在2025年有望达170亿好意思元,并在2025-2027年或将以CAGR=11%的复合增速增长,2027年有望粉碎200亿好意思元。

图31:内行光模块市集在2027年有望粉碎200亿好意思元

贵府起原:Lightcounting,源达信息证券研究所

国产光模块厂商在2023年内行光模块企业TOP10排行中占据7席。TOP10中国内企业为中际旭创(Innolight)、华为(Huawei)、光迅科技(Accelink)、海信(Hisense)、新易盛(Eoptolink)、华工正源(HGG)、索尔想光电(已被华西股份收购)。而在高端光模块领域,中际旭创已在2024年结尾1.6TG光模块批量出货,并加速对3.2T等更高端光模块时候的研发。

表10:中际旭创在2023年内行光模块企业排行中位居第一

|

2021 |

2022 |

2023 |

|

Ⅱ-Ⅳ&Innolight |

Innolight&Coherent |

Innolight |

|

Coherent |

||

|

Huawei(HiSilicon) |

Cisco(Acacia) |

Huawei(HiSilicon) |

|

Cisco(Acacia) |

Huawei(HiSilicon) |

Cisco(Acacia) |

|

Hisense |

Accelink |

Accelink |

|

Broadcom(Avago) |

Hisense |

Hisense |

|

Eoptolink |

Eoptolink |

Eoptolink |

|

Accelink |

HGG |

HGG |

|

Molex |

Intel |

Source Photonics |

|

Intel |

Source Photonics |

Marvell |

贵府起原:Lightcounting,源达信息证券研究所

六、投资建议

1.建议关切

豆包大模子产品力大幅进步,产品矩阵进一步丰富,并大幅裁减东说念主工智能大模子使用成本,配合豆包APP在末端应用渗入率的进步,有望推动AI应用的买卖隆盛。跟随AI应用需求增长,灵通算力高额需求缺口,推动算力基础设施成立。建议关切作事器、液冷诱导、芯片和光模块等领域的投资契机:

1)作事器:海潮信息、中科晨曦;

2)液冷诱导:英维克;

3)芯片:海光信息;

4)光模块:中际旭创、天孚通讯、光迅科技。

2.行业重心公司一致盈利预测

表11:万得一致盈利预测

|

公司 |

代码 |

归母净利润(亿元) |

PE |

总市值(亿元) |

||||

|

2023E |

2024E |

2025E |

2023E |

2024E |

2025E |

|||

|

海潮信息 |

000977.SZ |

22.9 |

28.5 |

34.0 |

34.2 |

27.5 |

23.0 |

781 |

|

中科晨曦 |

603019.SH |

21.7 |

26.6 |

32.0 |

50.0 |

40.7 |

33.9 |

1083 |

|

英维克 |

002837.SZ |

5.4 |

7.2 |

9.4 |

56.1 |

41.9 |

32.3 |

303 |

|

海光信息 |

688041.SH |

19.0 |

27.2 |

36.5 |

187.9 |

131.7 |

98.1 |

3579 |

|

中际旭创 |

300308.SZ |

53.4 |

88.0 |

108.9 |

27.5 |

16.7 |

13.5 |

1471 |

|

天孚通讯 |

300394.SZ |

14.4 |

23.2 |

30.3 |

36.9 |

22.9 |

17.6 |

531 |

|

光迅科技 |

002281.SZ |

7.8 |

10.9 |

13.7 |

56.7 |

40.5 |

32.3 |

440 |

贵府起原:Wind一致预期(2024/12/30),源达信息证券研究所

七、风险教导

算力本钱开支不足预期;

AI应用渗入不足预期;

宏不雅经济环境恶化;

竞争形态恶化。

投资评级讲明

|

行业评级 |

以敷陈日后的 6 个月内,证券相对于沪深 300 指数的涨跌幅为规范,投资建议的评级规范为: |

|

|

|

看 好: |

行业指数相对于沪深 300 指数发扬+10%以上 |

|

|

中 性: |

行业指数相对于沪深 300 指数发扬-10%~+10%以上 |

|

|

看 淡: |

行业指数相对于沪深 300 指数发扬-10%以下 |

|

公司评级 |

以敷陈日后的 6 个月内,行业指数相对于沪深 300 指数的涨跌幅为规范,投资建议的评级规范为: |

|

|

|

买 入: |

相对于恒生沪深 300 指数发扬+20%以上 |

|

|

增 抓: |

相对于沪深 300 指数发扬+10%~+20% |

|

|

中 性: |

相对于沪深 300 指数发扬-10%~+10%之间波动 |

|

|

减 抓: |

相对于沪深 300 指数发扬-10%以下 |

|

办公地址 |

||||||

|

||||||

分析师声明

作产品有中国证券业协会授予的证券投资商量执业履历并注册为证券分析师,以辛苦的事业派头,沉寂、客不雅地出具本敷陈。分析逻辑基于作家的事业清爽,本敷陈光显准确地反应了作家的研究不雅点。作家所得酬劳的任何部分不曾与,不与,也不将与本敷陈中的具体推选看法或不雅点而有径直或迤逦计议,特此声明。

要紧声明

河北源达信息时候股份有限公司具有证券投资商量业务履历,辩论证券业务许可证编号:911301001043661976。

本敷陈仅限中国大陆地区刊行,仅供河北源达信息时候股份有限公司(以下简称:本公司)的客户使用。本公司不会因秉承东说念主收到本敷陈而视其为客户。本敷陈的信息均起原于公开贵府,本公司对这些信息的准确性和好意思满性不作任何保证,也不保证所包含信息和建议不发生任何变更。本公司已戮力敷陈内容的客不雅、公正,但文中的不雅点、论断和建议仅供参考,不包含作家对质券价钱涨跌或市集走势确切定性判断。本敷陈中的信息或所表述的看法均不组成对任何东说念主的投资建议,投资者应当对本敷陈中的信息和看法进行沉寂评估。

本敷陈仅反应本公司于发布敷陈当日的判断,在不同期期,本公司不错发出其他与本敷陈所载信息不一致及有不同论断的敷陈;本敷陈所反应研究东说念主员的不同不雅点、视力及分析方法,并不代表本公司或其他附庸机构的态度。同期,本公司对本敷陈所含信息可在不发出示知的情形下作念出修改,投资者应当自行关切相应的更新或修改。

本公司及作家在自己所知情范围内,与本敷陈中所评价或推选的证券不存在法律法子条件走漏或采选截止、静默措施的利益冲突。

本敷陈版权仅为本公司通盘,未经籍面许可,任何机构和个东说念主不得以任何神气翻版、复制和发布。如援用须注明出处为源达信息证券研究所,且不得对本敷陈进行有悖痛快的援用、删省和修改。刊载或者转发本证券研究敷陈或者摘录的,应当注明本敷陈的发布东说念主和发布日历,教导使用证券研究敷陈的风险。未经授权刊载或者转发本敷陈的,本公司将保留向其根究法律背负的职权。

财务报表及辩论预测

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

背负剪辑:何俊熹 AG百家乐下三路技巧打法