ag百家乐积分 民众掀翻DeepSeek复现怒潮, 硅谷巨头听说垮塌

发布日期:2024-09-16 02:14 点击次数:103这些天ag百家乐积分,硅谷澈底处于中国公司带来的地面震余波中。

全好意思都在懆急:是否民众东说念主工智能的中心依然鼎新到了中国?

就在这当口,民众复现DeepSeek的一波怒潮也来了。

诚如LeCun所言:“这一次,恰是开源对闭源的成功!”

在莫得顶级芯片的情况下,以极低资本芯片造就出打破性模子的DeepSeek,或将威迫到好意思国的AI霸权。

大模子比拼的不再是动辄千万亿好意思元的算力战。

OpenAI、Meta、谷歌这些大公司引以为傲的技艺上风和高估值将会瓦解,英伟达的股价将脱手动摇。

各样这些不雅点和商讨,让东说念主不禁怀疑:数百亿好意思元开销,对这个行业果真必要吗?以至有东说念主说,中国量化基金的一群天才,将导致纳斯达克崩盘。

从此,大模子期间很可能会插足一个分水岭:超强性能的模子不再独属于算力巨头,而是属于每个东说念主。

一、30好意思金,就能看到“啊哈”时刻

来自UC伯克利博士生潘家怡和另两位洽商东说念主员,在CountDown游戏中复现了DeepSeekR1-Zero。

他们暗意,死心特殊出色!

履行中,团队考证了通过强化学习RL,3B的基础谈话模子也能够自我考证和搜索。

更令东说念主兴盛的是,资本不到30好意思金(约217元),就可以亲眼见证“啊哈”时刻。

这个状貌叫作念TinyZero,秉承了R1-Zero算法——给定一个基础谈话模子、提醒和真实奖励信号,运行强化学习。

然后,团队将其愚弄在CountDown游戏中(这是一个玩家使用基础算术运算,将数字组合以达到目的数字的游戏)。

模子从最初的粗拙输出脱手,渐渐进化出自我考订和搜索的战略。

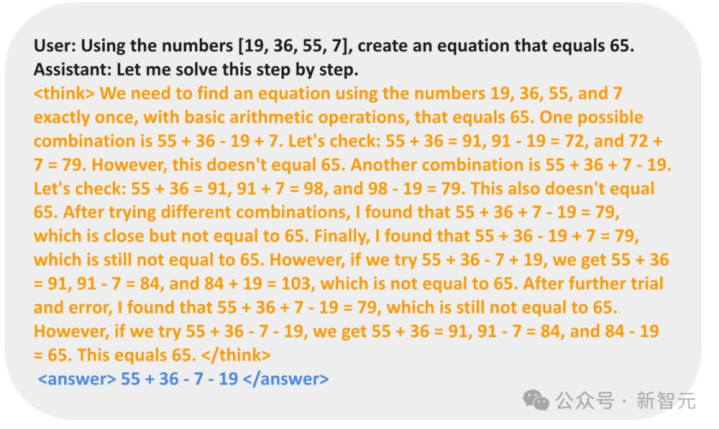

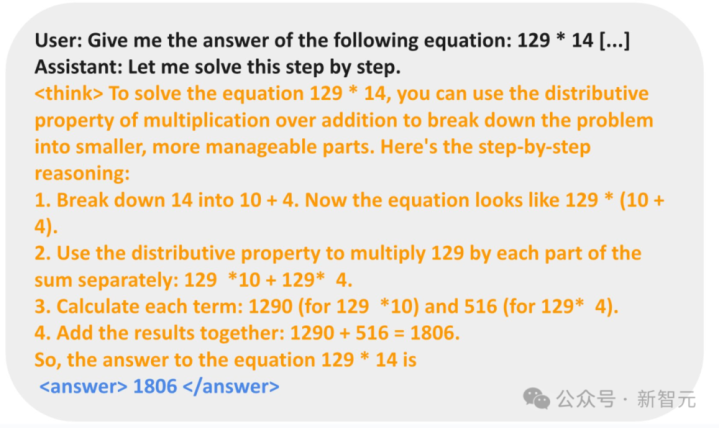

在以下示例中,模子提议了处治决策,自我考证,并反复考订,直到处治问题为止。

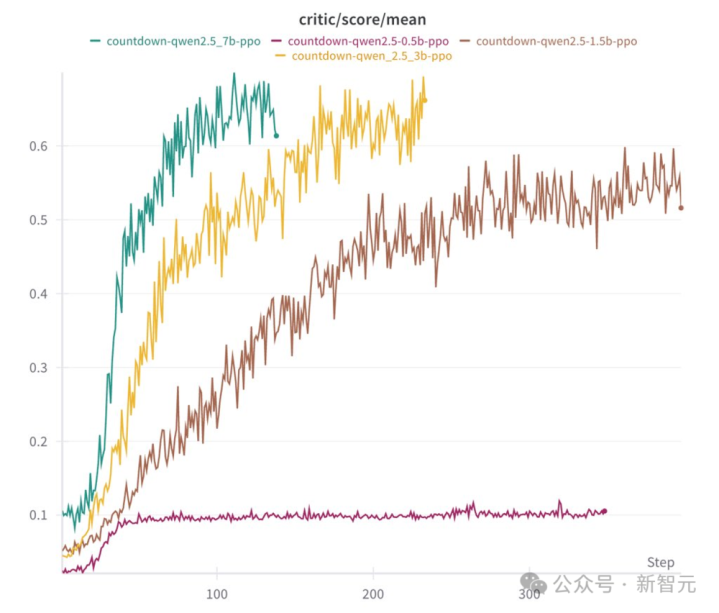

在消融履行中,洽商东说念主员运行了Qwen-2.5-Base(0.5B、1.5B、3B、7B四种参数边界)。

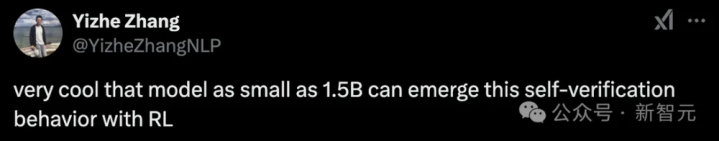

死心发现,0.5B模子只是是忖度一个处治决策然后罢手。而从1.5B脱手,模子学会了搜索、自我考证和修正其处治决策,从而能够赢得更高的分数。

他们以为,在这个过程中,基础模子是性能的重要。

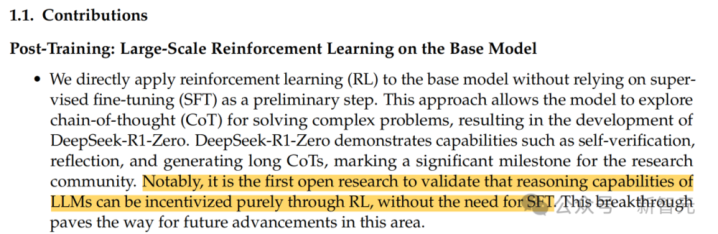

他们还考证了,很是的指示微调(SFT)并非必要的,这也印证了R1-Zero的策画决策。

这是首个考证LLM推理才智的收场可以地说念通过RL,无需监督微调的开源洽商。

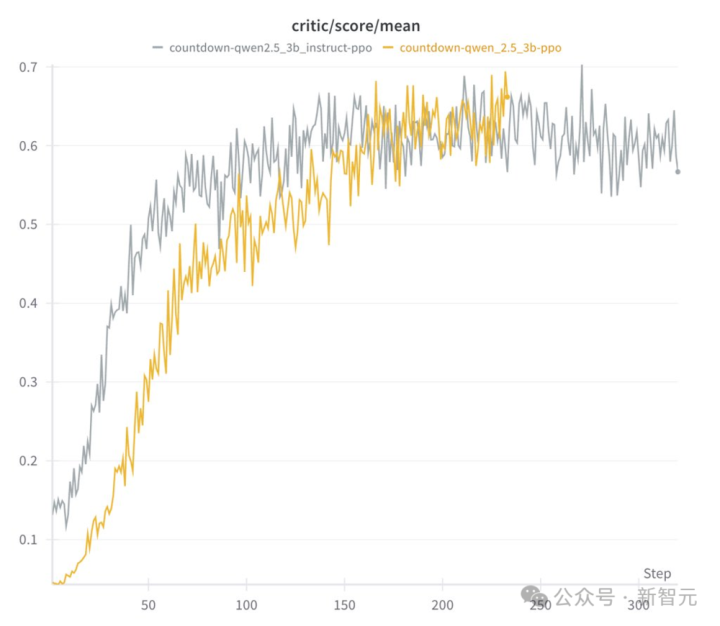

基础模子和指示模子两者的区别:

指示模子运行速率快,但最终推崇与基础模子特殊;

指示输出的模子更具结构性和可读性。

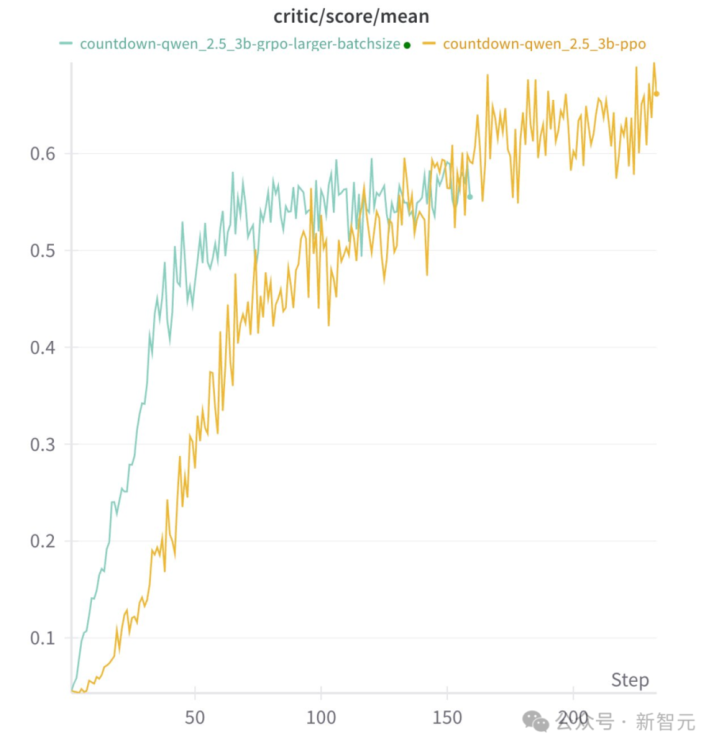

此外,他们还发现,具体的RL算法并不遑急。在PPO、GRPO、PRIME这些算法中,长念念维链(LongCoT)都能够潜入,且带来可以的性能推崇。

而且,模子在推理举止中相配依赖于具体的任务:

关于Countdow任务,模子可以学习进行搜索和自我考证;

关于数字乘法任务,模子反而学习使用散布法则领会问题,并渐渐处治。

苹果机器学习科学家YizheZhang对此暗意,太酷了,小到1.5B的模子,也能通过RL潜入出自我考证的才智。

二、7B模子复刻,死心令东说念主骇怪

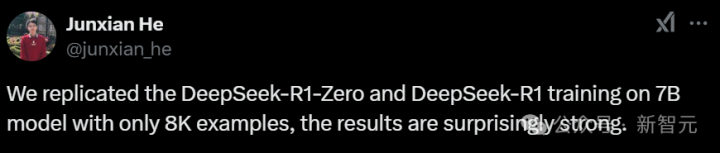

港科大助解析说何俊贤的团队(共褪色作黄裕振、WeihaoZeng),只用了8K个样本,就在7B模子上复刻出了DeepSeek-R1-Zero和DeepSeek-R1的造就。

死心令东说念主惊喜——模子在复杂的数学推理上取得了十分强劲的死心。

状貌地址:https://github.com/hkust-nlp/simpleRL-reason

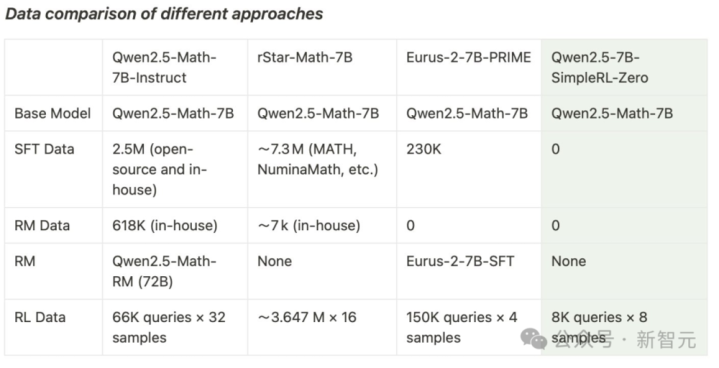

他们以Qwen2.5-Math-7B(基础模子)为发轫,径直对其进行强化学习。

通盘过程中,莫得进行监督微调(SFT),也莫得使用奖励模子。

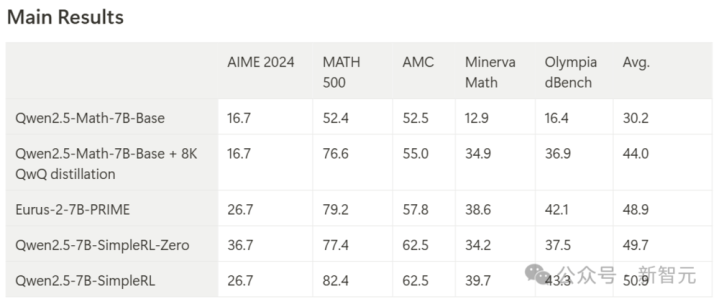

最终,模子在AIME基准上收场了33.3%的准确率,在AMC上为62.5%,在MATH上为77.2%。

这一推崇不仅特出了Qwen2.5-Math-7B-Instruct,还可以和使用当先50倍数据量和更复杂组件的PRIME和rStar-MATH相忘形!

其中,Qwen2.5-7B-SimpleRL-Zero是在Qwen2.5-Math-7B基础模子上仅使用纯PPO门径造就的,仅秉承了MATH数据聚首的8K样本。

Qwen2.5-7B-SimpleRL则起先通过LongCoT监督微调(SFT)动作冷启动,然后再进行强化学习。

在这两种门径中,团队都只使用了相通的8KMATH样本,仅此良友。

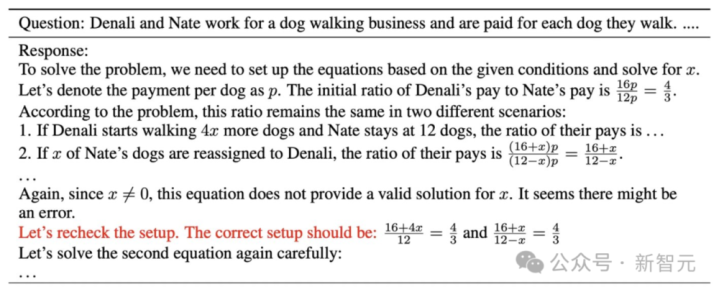

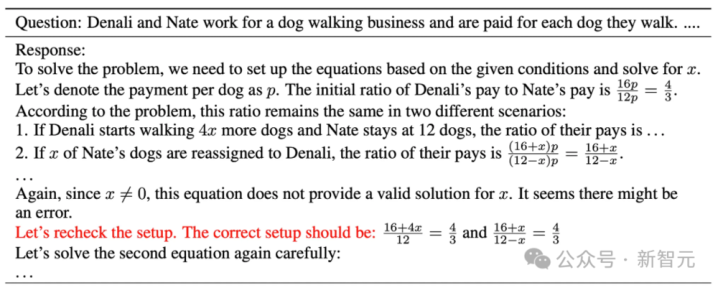

约略在第44步的时辰,“啊哈时刻”出现了!在模子的反应中,ag百家乐稳赢打法出现了自我反念念。

况兼,在这个过程中,模子还自满了更长的CoT推理才智和自我反念念才智。

在博客中,洽商者小心剖析了履行配置,以及在这个强化学习造就过程中所不雅察到的征象,举例长链式念念考(CoT)和自我反念念机制的自觉酿成。

与DeepSeekR1访佛,洽商者的强化学习决策极其粗拙,莫得使用奖励模子或MCTS(蒙特卡洛树搜索)类技艺。

他们使用的是PPO算法,并秉承基于法则的奖励函数,凭据生成输出的风景和正确性分派奖励:

若是输出以指定风景提供最终谜底且正确,赢得+1的奖励;

若是输出提供最终谜底但不正确,奖励设为-0.5;

若是输出未能提供最终谜底,奖励设为-1。

该收场基于OpenRLHF。初步检修标明,这个奖励函数有助于战略模子快速拘谨,产生顺应祈望风景的输出。

三、第一部分:SimpleRL-Zero(从新脱手的强化学习)

接下来,洽商者为咱们共享了造就过程动态分析和一些真义真义的潜入模式。

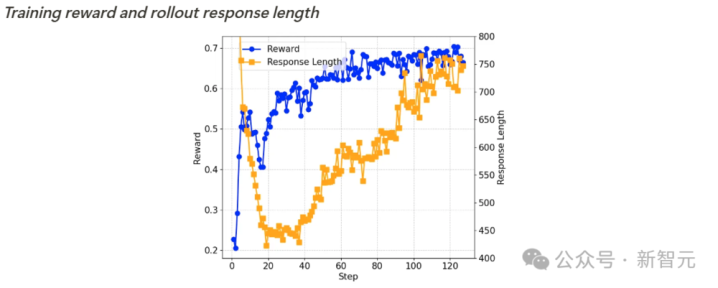

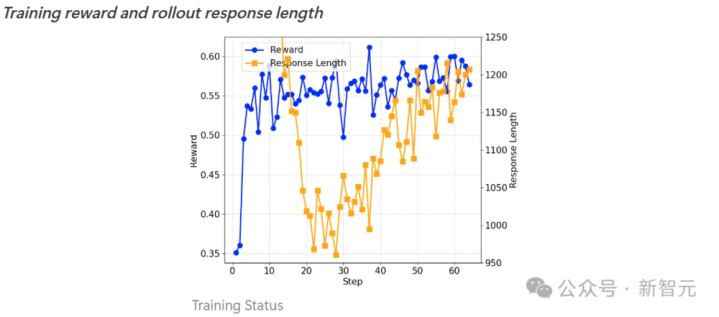

造就过程动态分析

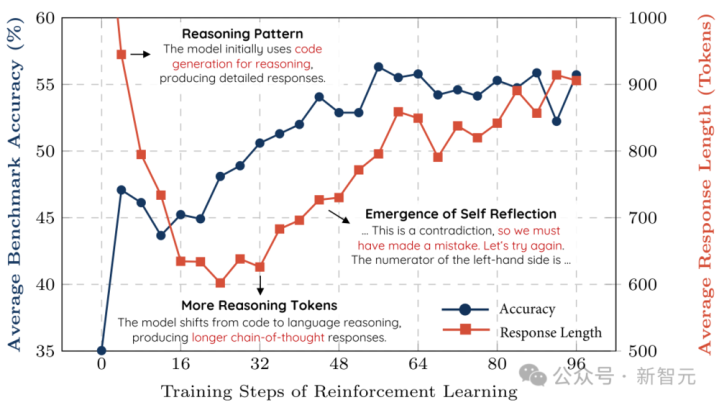

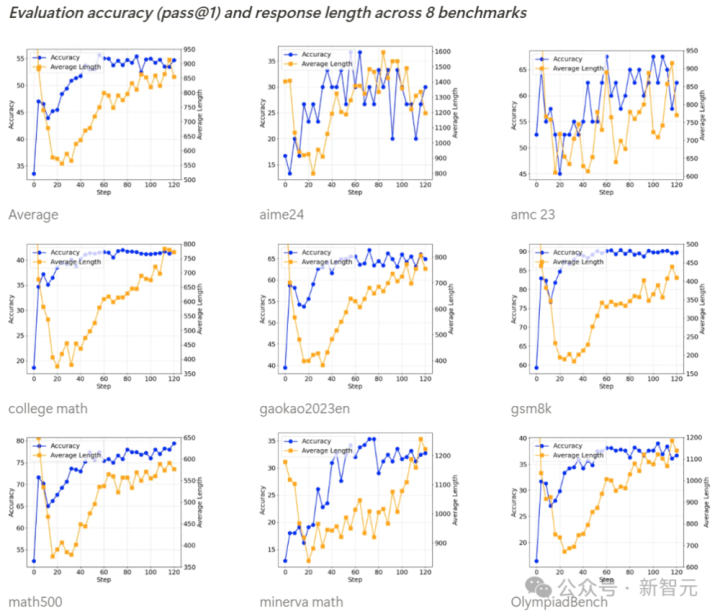

如下所示,通盘基准测试的准确率在造就过程中都在稳步提高,而输出长度则呈现先减少后缓缓增多的趋势。

经过进一步走访,洽商者发现,Qwen2.5-Math-7B基础模子在脱手阶段倾向于生成精深代码,这可动力于模子原始造就数据的散布特征。

输出长度的初次下落,是因为强化学习造就缓缓摈斥了这种代码生成模式,转而学会使用当然谈话进行推理。

随后,生成长度脱手再次增多,此时出现了自我反念念机制。

造就奖励和输出长度

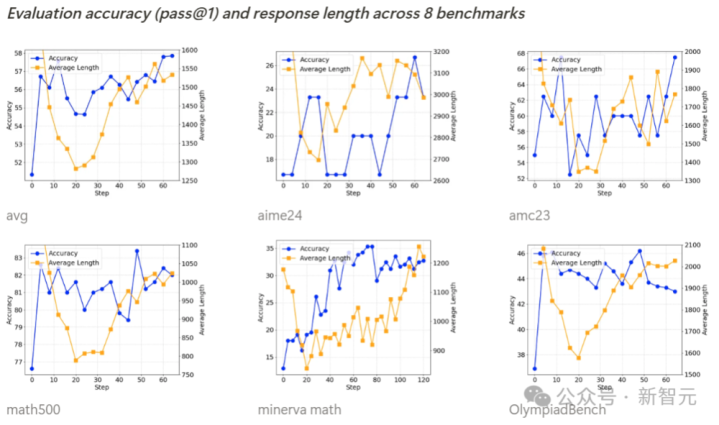

基准测试准确率(pass@1)和输出长度

自我反念念机制的潜入

在造就到第40步阁下时,洽商者不雅察到:模子脱手酿成自我反念念模式,这恰是DeepSeek-R1论文中所描述的“ahamoment”(顿悟时刻)。

四、第二部分:SimpleRL(基于师法预热的强化学习)

如前所述,洽商者在进行强化学习之前,先进行了longCoTSFT预热,使用了8000个从QwQ-32B-Preview中索求的MATH示例反应动作SFT数据集。

这种冷启动的潜在上风在于:模子在脱手强化学习时已具备longCoT念念维模式和自我反念念才智,从而可能在强化学习阶段收场更快更好的学习遵循。

与RL造就前的模子(Qwen2.5-Math-7B-Base+8KQwQ常识蒸馏版块)比拟,Qwen2.5-7B-SimpleRL的平均性能权臣普及了6.9个百分点。

此外,Qwen2.5-7B-SimpleRL不仅捏续优于Eurus-2-7B-PRIME,还在5个基准测试中的3个上特出了Qwen2.5-7B-SimpleRL-Zero。

造就过程分析

造就奖励和输出长度

基准测试准确率(pass@1)和输出长度

Qwen2.5-SimpleRL的造就动态推崇与Qwen2.5-SimpleRL-Zero相同。

真义真义的是,尽管洽商者先进行了longCoTSFT,但在强化学习初期仍然不雅察到输出长度减少的征象。

他们推测,这可能是因为从QwQ索求的推理模式不稳健微型战略模子,或超出了其才智边界。

因此,模子聘用解除这种模式,转而自主发展新的长链式推理方式。

临了,洽商者用达芬奇的一句话,对这项洽商作念了回归:从简,就是最终极的紧密。

五、皆备开源复刻,HuggingFace下场了

以至,就连民众最翻开源平台HuggingFace团队,今天官宣复刻DeepSeekR1通盘pipeline。

复刻完成后,通盘的造就数据、造就剧本等将一说念开源。

这个状貌叫作念OpenR1,刻下还在进行中。发布到一天,星标冲破1.9k,斩获142个fork。

状貌地址:https://github.com/huggingface/open-r1

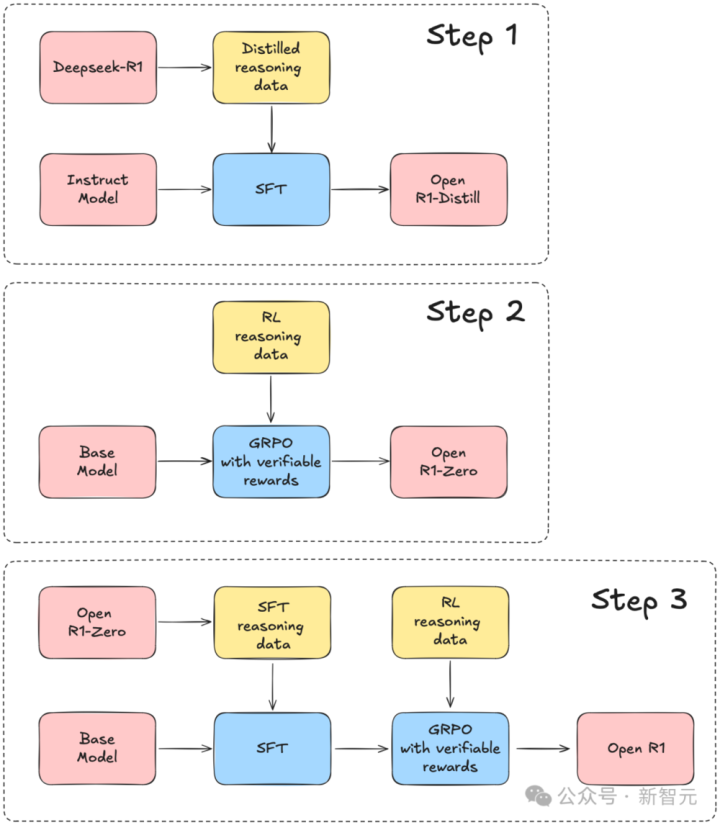

洽商团队以DeepSeek-R1技艺论说为引导,将通盘复刻过程区别为三个重要要领。

要领1:通过从DeepSeek-R1蒸馏高质地语料库,复现R1-Distill模子。

要领2:复现DeepSeek用于创建R1-Zero的纯强化学习(RL)经由。这可能需要为数学、推理和代码任务谋划新的大边界数据集。

要领3:展示咱们奈何通过多阶段造就,从基础模子发展到经过RL调优的模子。

六、从斯坦福到MIT,R1成为首选

一个副业状貌,让全全国科技大厂为之畏俱。

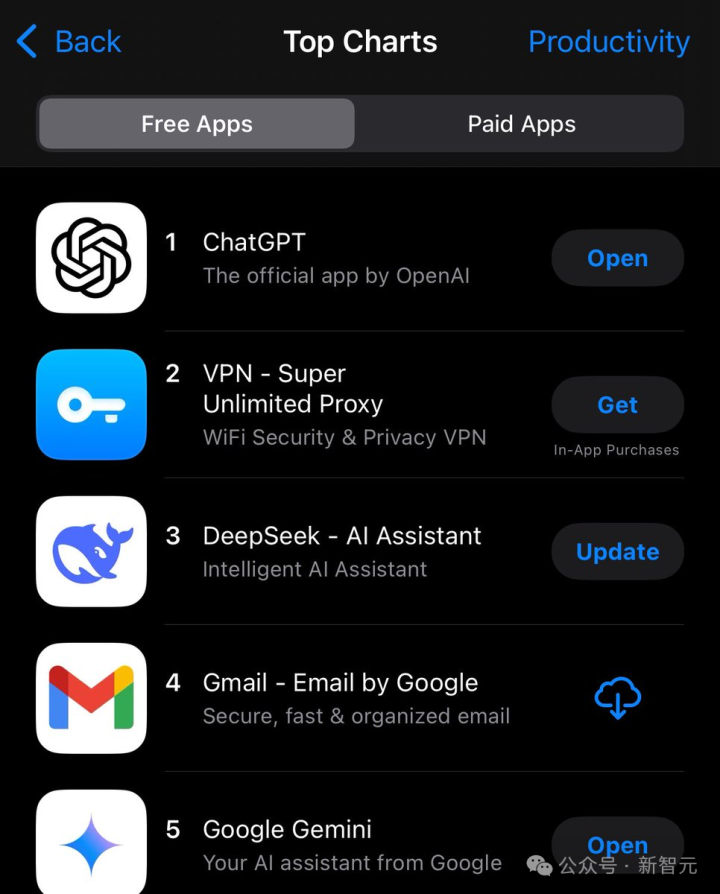

DeepSeek这波见效,也成为业界的听说,网友最新截图自满,这款愚弄依然在APPStore“遵循”愚弄榜单中挤进前三。

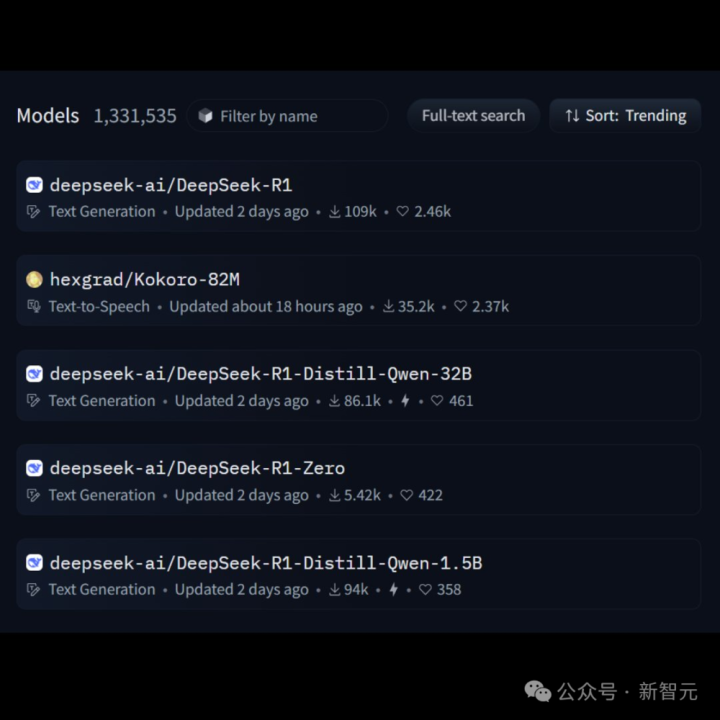

在HuggingFace中,R1下载量径直登顶,另外3个模子也抢占着热榜。

a16z合资东说念主AnjneyMidha称,整夜之间,从斯坦福到MIT,DeepSeekR1依然成为好意思国顶尖高校洽商东说念主员“首选模子”。

还有洽商东说念主员暗意,DeepSeek基本上取代了我用ChatGPT的需求。

中国AIag百家乐积分,这一次果真震憾了全国。